Securepoint Cluster Konfiguration

Best Practice

Wichtige Information

Aktuelle Software

Installieren sie immer die neueste Version der Software. Nur in der aktuellen Version sind die neusten Funktionen, Sicherheits-Erweiterungen und Fehlerkorrekturen enthalten.

Für weiterführende Informationen, kontaktieren sie unseren Support:

E-Mail: support@securepoint.de

Telefon: 04131 2401 0

Oder nutzen sie unser Support Portal:

http://support.securepoint.de

Einleitung zur Cluster-Konfiguration

Die Cluster-Konfiguration dient der Absicherung geschäftskritischer Prozesse. Securepoint stellt dazu einen Aktiv/Passiv-Cluster zur Verfügung. Die UTMs innerhalb des Clusters überwachen sich gegenseitig und schalten bei Bedarf automatisch auf das Gerät mit dem besten Status um. Bei korrekter Konfiguration und eingesetzter Hardware ist ein manueller Eingriff des Administrators dabei nicht mehr notwendig.

Voraussetzungen

Zum Cluster-Betrieb sind folgende Voraussetzungen notwendig:

Eine Cluster-Lizenz:

Zur Konfiguration und den Betrieb des Clusters benötigen sie eine gültige Lizenz. Die Cluster-Lizenz beantragen sie im Securepoint Reseller Portal:

https://my.securepoint.de/index/login

Als Endkunde wenden sie sich bitte an einen autorisierten Securepoint Reseller:

http://www.securepoint.de/partnerprogramm/

|

Achtung! Die Menüpunkte zur Cluster-Konfiguration sind erst sichtbar, wenn eine v11-Cluster-Lizenz importiert wurde. |

Zwei identische Appliances mit mindestens 3 Ethernet Schnittstellen und gleicher Firmware:

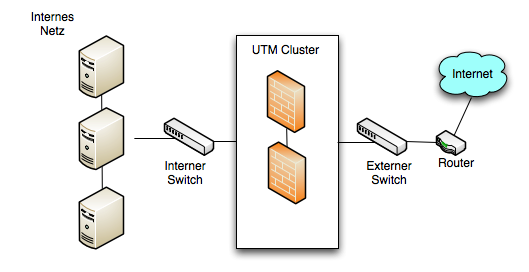

Im einfachsten Fall (siehe Abbildung 1.1) haben sie ein Eingangs-Interface (internes LAN) und ein Ausgangs-Interface (externes LAN). Die dritte Schnittstelle wird für den Abgleich der Konfiguration und das Connection-Tracking benötigt. Diese Schnittstelle - im Folgenden auch als Hotwire-Schnittstelle bezeichnet - kann keine weitere Netzwerkfunktion übernehmen.

|

Achtung! Die Firmware auf beiden Maschinen muss exakt den gleichen Stand haben! |

Die eingesetzten Switches und Router unterstützen „gratuitous ARP<ref name="ftn1">http://de.wikipedia.org/wiki/Address_Resolution_Protocol#Gratuitous_ARP</ref>“:

Wenn es im Cluster zum Master/Backup Wechsel kommt, entweder absichtlich oder aufgrund eines Fehlers, sendet die neu im Cluster aktive UTM, „gratuitous ARP“ Pakete an ihre Umgebung, um die neuen MAC Adresse bekannt zu geben. Unterstützen die Switches bzw. Router diese Funktion nicht, können sie erst verzögert über die neu im Cluster aktive UTM kommunizieren.

Funktionsweise des Clusters

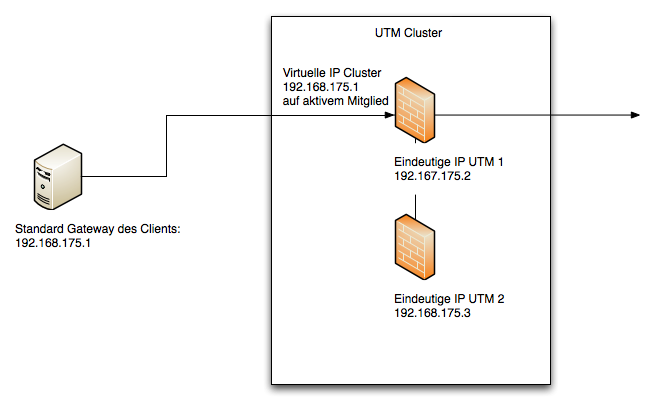

Der Cluster verwendet eindeutige IP- und MAC-Adressen für die beiden Mitglieder des Clusters und virtuelle IP-Adressen für den Cluster selber. Die virtuellen IP-Adressen sind nur auf dem aktiven Mitglied des Clusters aktiv. Fällt das aktive Mitglied des Clusters ganz oder teilweise aus, dann wechseln die virtuellen IP-Adressen auf das zweite Mitglied des Clusters.

Für die Clients und Server in einer Clusterkonfiguration ist die virtuelle IP-Adresse der Kommunikationspartner im Routing (also zum Beispiel das Standard Gateway, siehe Abb. 1.2).

Das Cluster VRR Protokoll

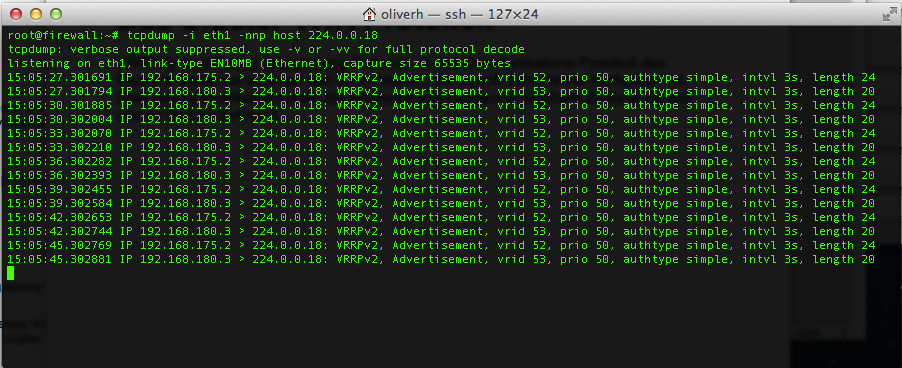

VRRP (Virtual Router Redundancy Protocol) ist das Kommunikationsprotokoll des Clusters. Es ist nur auf den Schnittstellen aktiv, die als HA-Schnittstelle konfiguriert sind. Über dieses Protokoll ermitteln die Mitglieder des Clusters, in welchem Zustand sie und ihr Partner sich befinden.

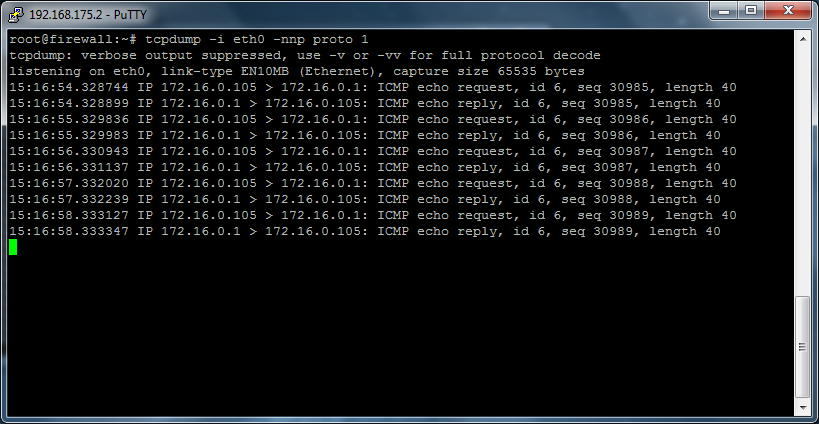

Mit Hilfe von tcpdump können sie das Protokoll auf einer HA-Schnittstelle sichtbar machen:

Es sind keine speziellen Firewall Regeln notwendig, um die Kommunikation mit dem VRR-Protokoll zu ermöglichen.

Umschalten des Clusters

Das Umschalten innerhalb des Clusters kann unter folgenden Bedingungen passieren:

- Das aktive Mitglied eines Clusters wird neu gestartet oder ganz heruntergefahren.

- Ein oder mehrere HA-Interfaces haben keinen physikalischen Link mehr.

- Der Link eines HA-Interfaces ist aktiv, aber aufgrund eines defekten oder falsch konfigurierten Switches kommen die VRRP Pakete nicht beim Cluster Partner an.

- Die Cluster Funktion wird auf dem aktiven Cluster-Partner durch den Administrator deaktiviert.

Falls sie mehr als zwei HA Interfaces aktiviert haben, besteht im Fehlerfall die Möglichkeit, dass eine unterschiedliche Anzahl von HA-Interfaces nicht mehr kommunizieren können. In diesem Fall wird die UTM das aktive Mitglied werden, auf der die meisten Interfaces einen Link haben, solange sich die UTMs über wenigstens ein HA-Interface noch sehen. Sehen sich die UTMs auf keinem Interface mehr, gehen beide davon aus, dass das zweite Mitglied des Clusters nicht mehr vorhanden ist und beide werden aktiv im Cluster.

Tabelle, Verhalten im Cluster, Beispiel zwei HA-Interfaces:

| HA Interface 1 | HA Interface 2 | UTM 1 Status | UTM 2 Status |

|---|---|---|---|

| UTM 1 UP, UTM 2 UP | UTM 1 UP, UTM 2 UP | ||

| UTM 1 DOWN, UTM 2 UP | UTM 1 UP, UTM 2 UP | ||

| UTM 1 DOWN, UTM 2 DOWN | UTM 1 UP, UTM 2 UP | ||

| UTM 1 DOWN, UTM 2 DOWN | UTM 1 UP, UTM 2 DOWN | ||

| UTM 1 DOWN, UTM 2 DOWN | UTM 1 DOWN, UTM 2 DOWN |

Hierbei ist zu beachten, dass UTM-1 eine höhere Priorität als UTM-2 hat. Ist der Zustand in der Tabelle aktiv und als rot gekennzeichnet bedeutet das, dass sich die beiden Mitglieder des Clusters nicht mehr sehen und davon ausgehen, dass der jeweils andere Partner nicht mehr vorhanden ist. Beide Mitglieder des Clusters sind dann aktiv. Eine Netzwerkkommunikation ist dann allerdings generell nicht mehr möglich, da das Problem in der Umgebung liegt.

Hotwire-Interface

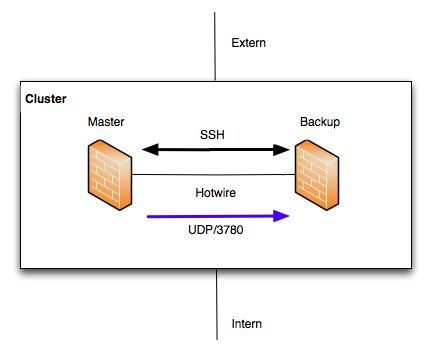

Das Hotwire-Interface ist ein exklusives Interface, welches nur zum Synchronisieren der Konfiguration der Cluster-Mitglieder und Abgleich der laufenden Verbindungen (Connection-Tracking) verwendet wird. Dieses Interface hat keine weitere Funktion und sollte bei der Auswahl der Appliance entsprechend einkalkuliert werden.

Für die Synchronisation der Konfiguration wird das SSH-Protokoll (TCP/22) verwendet. Das Connection-Tracking wird über den Port 3780 (UDP) abgeglichen. Ist ein Ethernet-Interface als Hotwire gekennzeichnet, werden die Regeln für die Kommunikation automatisch generiert. Für die SSH-Verbindung müssen öffentliche Schlüssel zwischen den Mitgliedern des Clusters ausgetauscht werden. Der Abgleich der Konfiguration kann in beide Richtungen zwischen den Mitgliedern des Cluster erfolgen. Das Connection-Tracking wird immer automatisch von dem Master im Cluster zum Backup übertragen (Abb. 1.3).

Konfiguration abgleichen

Über die Hotwire-Schnittstelle wird die Konfiguration synchronisiert. Änderungen die auf der einen Maschinen im Cluster gemacht wurden, können über diese Schnittstelle auf das andere Gerät übertragen werden. In der Regel ist die Konfiguration nach der Inbetriebnahme des Clusters also nur noch auf einer Maschine notwendig. Wir empfehlen, dazu die Master zu verwenden. Der Abgleich erfolgt immer manuell. Der Administrator entscheidet, wann er die Konfiguration im Cluster abgleichen möchte.

Folgende Konfigurations-Punkte werden nicht abgeglichen:

- IP-Adressen die eindeutig zu einer Maschine gehören und die auf Ethernet- oder VLAN- Schnittstellen konfiguriert wurden. Das sind die IP-Adressen, die Sie im Webinterface unter dem Punkt Netzwerk -> Netzwerkkonfiguration einstellen. Wenn Sie ein Ethernet- oder VLAN-Interface neu erzeugen, wird dies sehr wohl übertragen, aber nicht die Information über die IP-Adressen dieser Schnittstelle. Diese müssen bei Bedarf manuell auf dem Cluster-Mitglied konfiguriert werden und sind immer eindeutig einer UTM zugewiesen. Verwechseln Sie diese IP-Adressen nicht mit virtuellen IPs auf einem HA-Interface, die sich beide Maschinen im Cluster teilen.

- Active-Directory-Appliance-Account. Dieser Account ist immer eindeutig im AD. Erstellen sie unterschiedliche Namen auf beiden Maschinen und melden sie sich getrennt am Active Directory an.

Beispiel-Konfiguration: Externes DSL Modem

In diesem Beispiel wird eine Konfiguration aufgezeigt, mit der Sie einen UTM-Cluster an einer DSL-Leitung betreiben können. Die Einwahl erfolgt direkt durch die UTM.

Netzwerkkonfiguration:

Erstes Mitglied des Clusters (UTM 1)

Interne IP-Adresse: 192.168.175.2/24

Externe DSL Verbindung mittels PPPoE.

Hotwire-IP-Adresse:192.168.180.2/24

Zweites Mitglied des Clusters (UTM 2)

Interne IP-Adresse:192.168.175.3/24

Externe DSL Verbindung mittels PPPoE.

Hotwire-IP-Adresse:192.168.180.3/24

Als virtuelle IP-Adresse wird 192.168.175.1/24 definiert. Diese IP-Adresse ist das Standard-Gateway des internen Netzwerks.

Inbetriebnahme der UTMs

Verwenden Sie für die Inbetriebnahme den Installationsassistenten der UTM. Stellen sie sicher, dass das externe Interface noch nicht am DSL Modem angeschlossen ist, um eine evtl. Doppeleinwahl zu verhindern. Die Konfiguration der beiden UTMs sollte sich bis zu diesem Zeitpunkt nur durch die interne IP-Adresse unterscheiden. Importieren sie die erworbene Cluster-Lizenz im letzten Schritt des Wizards und starten sie die Maschinen nach Abschluss des Assistenten neu.

Sind die beiden UTMs mit dem internen Switch verbunden, sollten sie nun von ihrem administrativen Client auf beide Geräte gelangen.

Hotwire-Interface

Verbinden sie nun beide UTMs physikalisch mit dem von ihnen ausgewählten Hotwire Interface. Dieses muss auf den Maschinen der selbe Port sein, zum Beispiel LAN 3.

Cluster-Konfiguration

Die UTMs haben innerhalb des Clusters eine unterschiedliche Priorität. Die höhere Priorität hat der Master, die niedrigere das Backup-System. In unserem Beispiel wird die UTM mit der eindeutigen internen IP-Adresse 192.168.175.2 Master sein. Loggen sie sich auf diese Maschine mittels des Web-Interfaces ein.

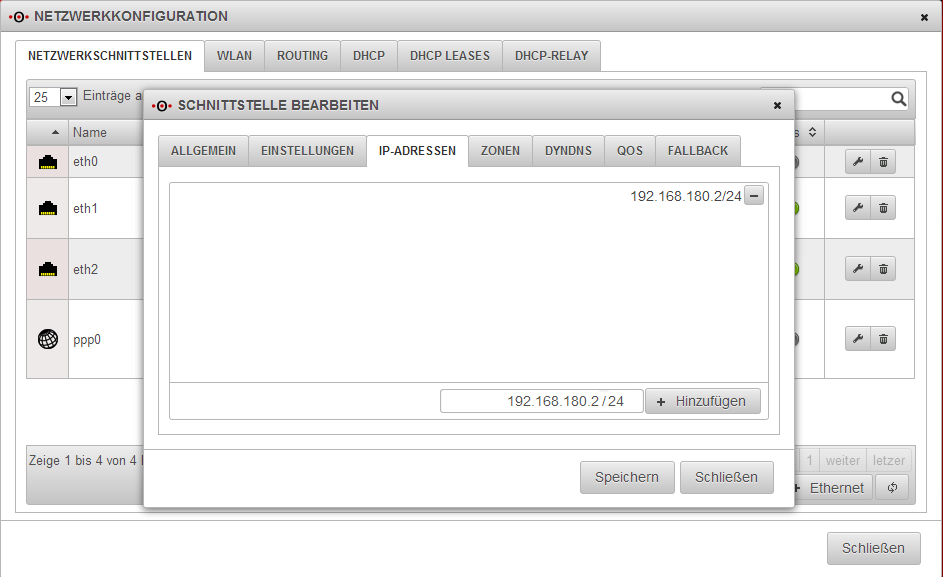

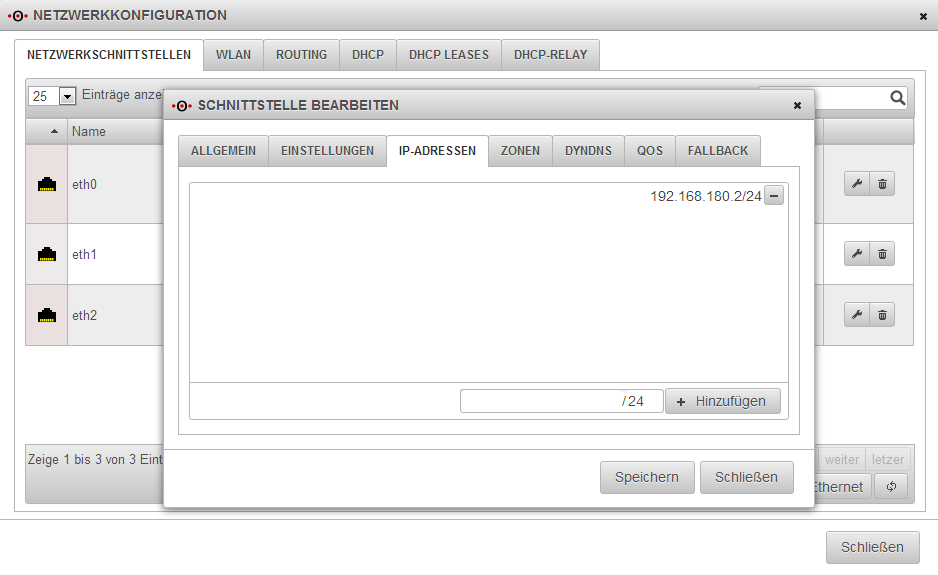

Öffnen sie nun den Netzwerk Dialog, zu finden unter dem Menüpunkt Netzwerk -> Netzwerkkonfiguration. Dort fügen sie die IP-Adresse des zukünftigen Hotwire-Interfaces hinzu. In unserem Fall bekommt LAN3 (eth2) die IP-Adresse 192.168.180.2/24.

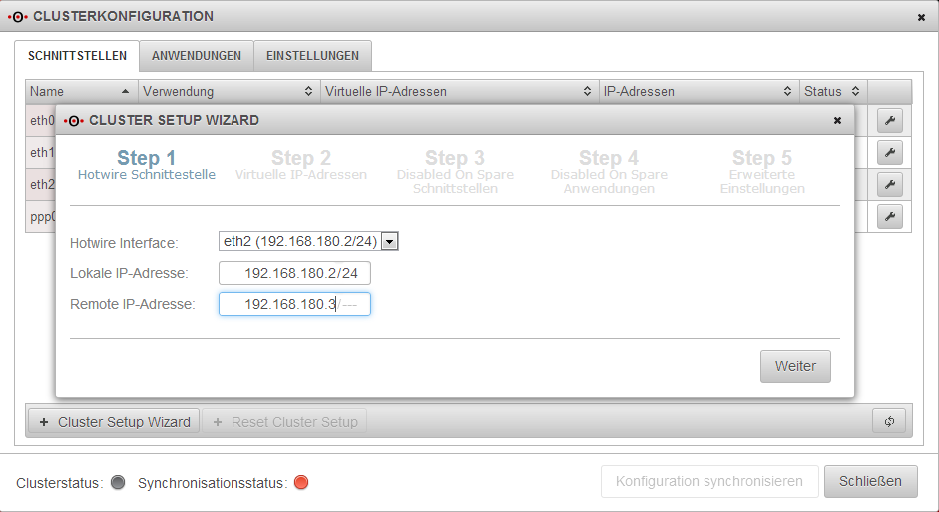

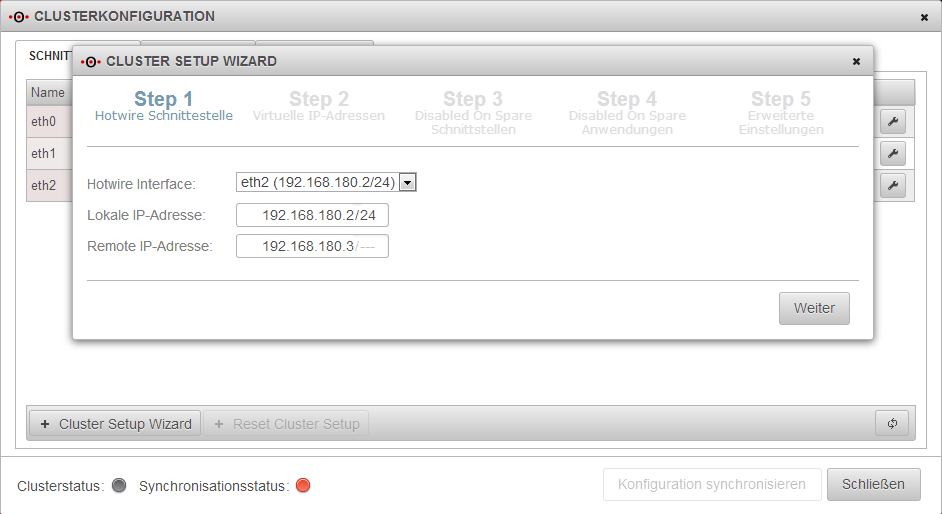

Im nächsten Schritt öffnen Sie den Cluster-Dialog (Netzwerk -> Clusterkonfiguration) und starten sie den Cluster Setup Wizard, wählen die Hotwire-Schnittstelle aus und geben die IP-Adresse der Hotwire Gegenstelle an.

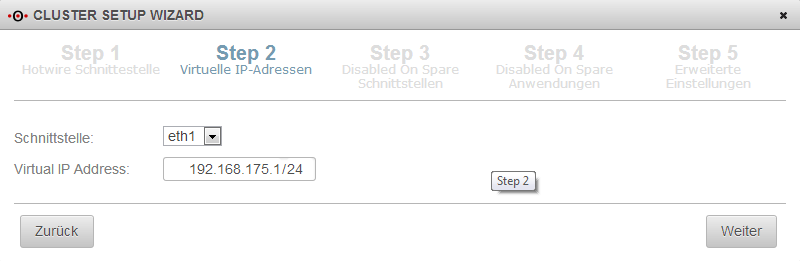

In Step 2 des Wizards wählen sie das zukünftige HA-Interface aus. In unserem Fall ist das die interne Schnittstelle. Die virtuelle IP-Adresse soll 192.168.175.1 sein. Sie können auf eine HA-Schnittstelle auch mehrere virtuelle IP-Adressen setzen. Diese IP-Adressen müssen nicht in der gleichen Broadcast Domain<ref name="ftn2">http://de.wikipedia.org/wiki/Broadcast_Domain</ref> der anderen IP-Adressen liegen. Nachdem sie den Wizard durchlaufen haben, können auch weitere HA-Schnittstellen konfiguriert werden.

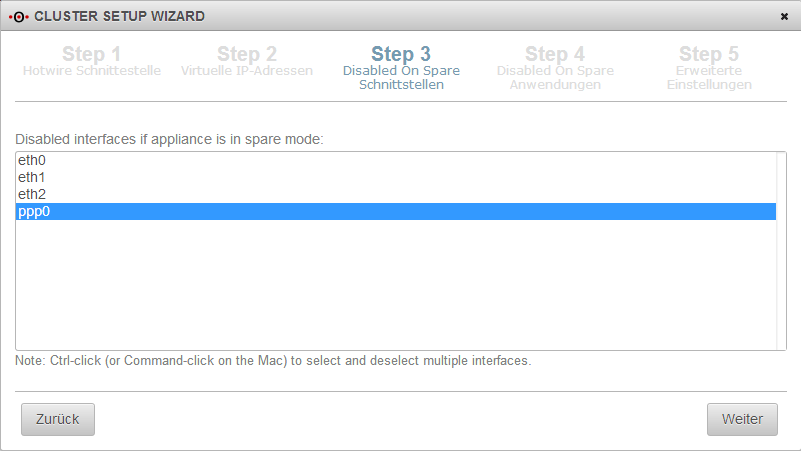

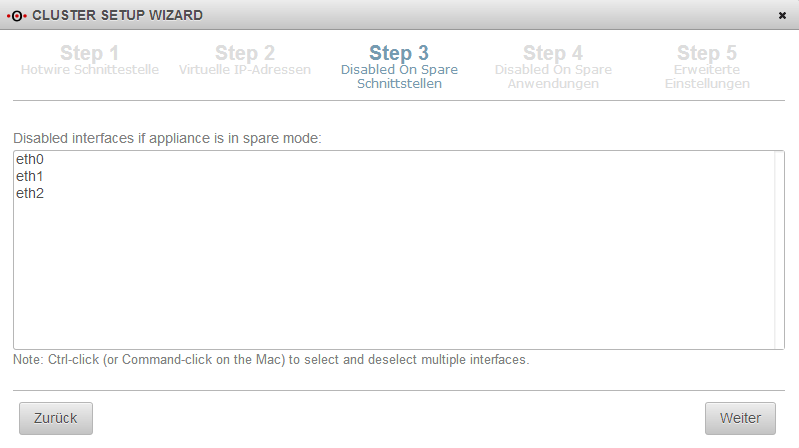

Im Step 3 des Wizards werden die Schnittstellen definiert, die auf dem Backup System (auch Spare genannt) nicht hochgefahren werden. In unserer Konfiguration wollen wir das nicht für ppp0 (DSL Interface). Die Einwahl soll nur durch die gerade aktive UTM im Cluster (Master) erfolgen. So ist es ihnen möglich, beide externen Interfaces der UTM an das DSL Modem anzuschliessen. Falls ihr Modem nur einen LAN Port besitzt, verwenden sie einen extra Switch.

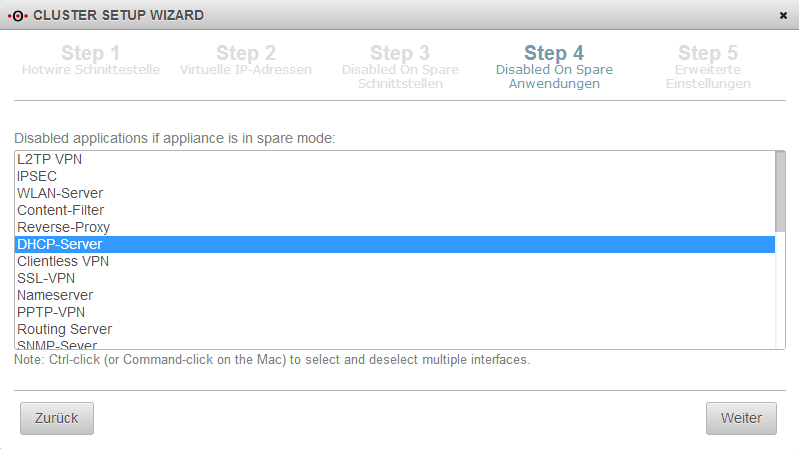

Im nächsten Schritt können sie Applikationen definieren die auf dem Backup System nicht aktiv sein sollen. Das Verhalten entspricht dem Schritt 3. Wir wählen hier die Applikation DHCP Server aus, falls die UTM auch als DHCP Server agieren soll, also den Clients im internen Netz IP-Adressen vergeben soll. Falls sie eine UTM verwenden, die auch als Access Point dient, deaktivieren sie hier auch die Applikation WLAN-Server.

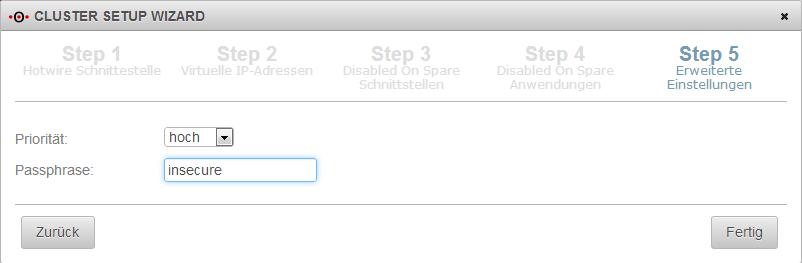

Im letzten Schritt des Wizards legen sie die Passphrase für die Kommunikation der beiden UTMs auf den HA Schnittstellen fest (VRR Protokoll) und die Priorität der aktuellen Appliance. Wir möchten, dass diese UTM die höhere Priorität hat, also im Regelfall Master ist.

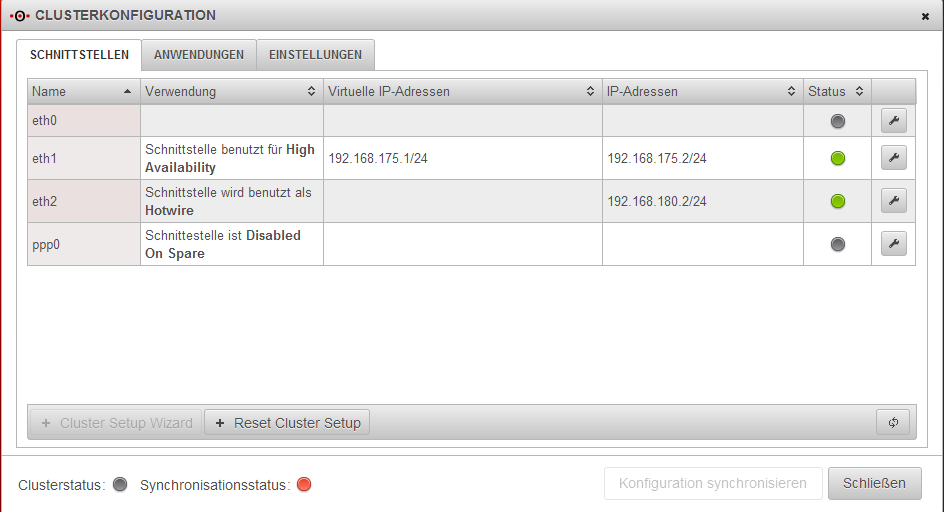

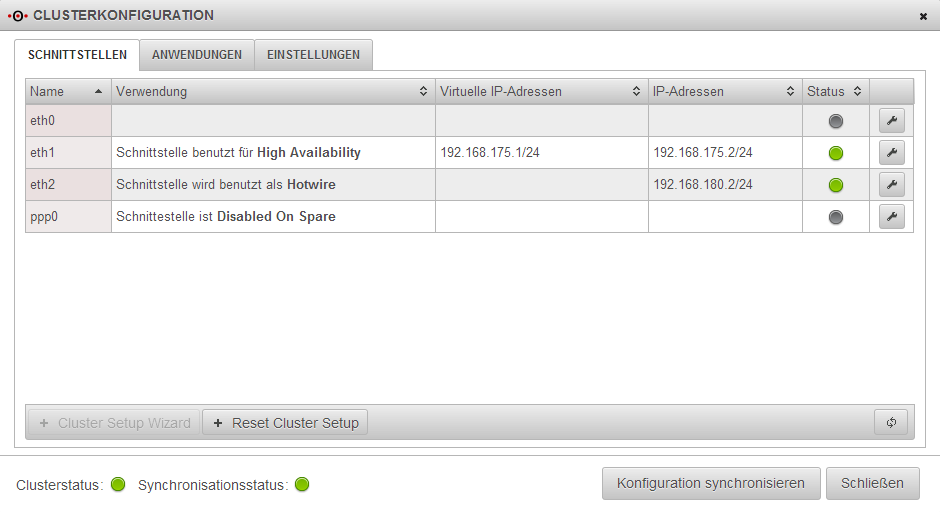

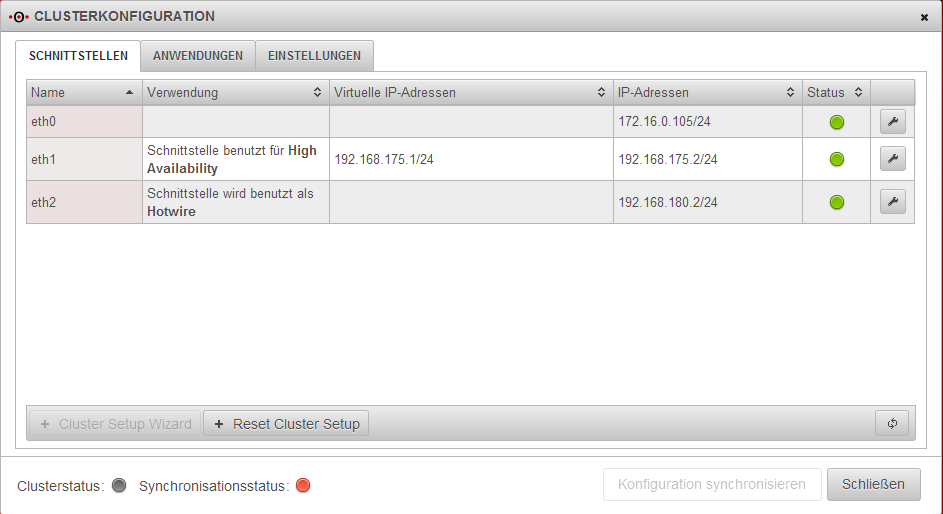

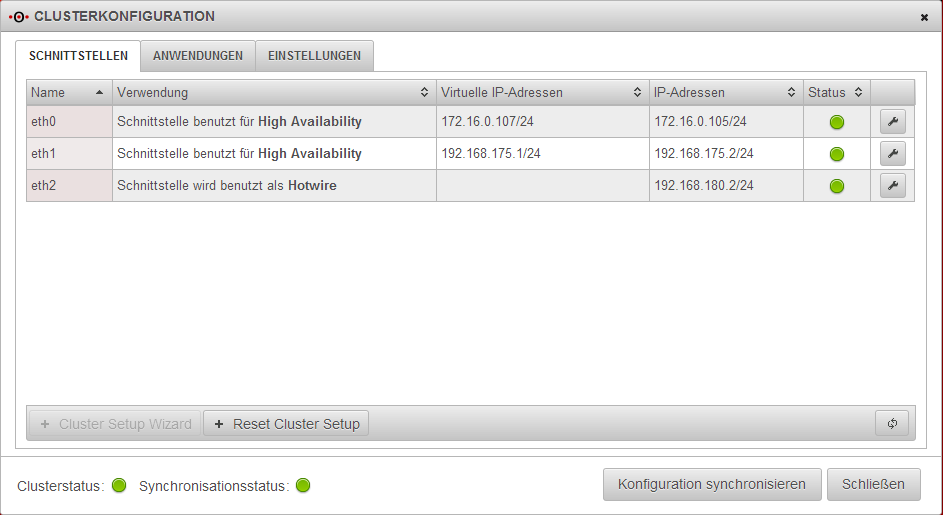

Die Konfiguration sieht nun wie folgt aus. Der Clusterstatus zeigt noch keinen Zustand an, weil der Cluster noch nicht auf aktiv geschaltet ist. Der Synchronisationsstatus steht auf rot, weil die Gegenstelle nicht erreichbar ist.

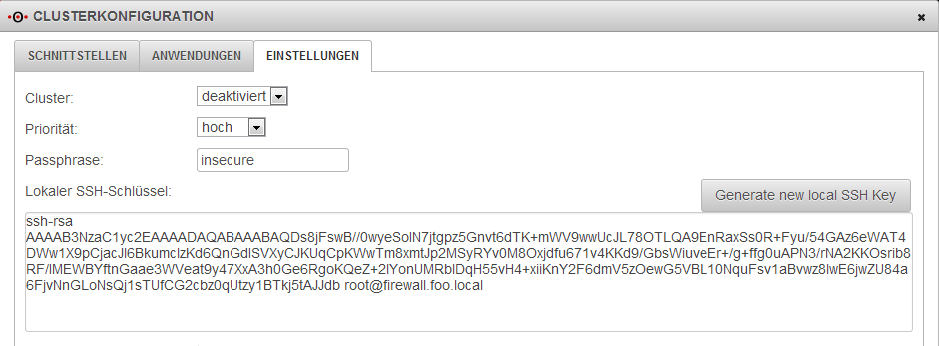

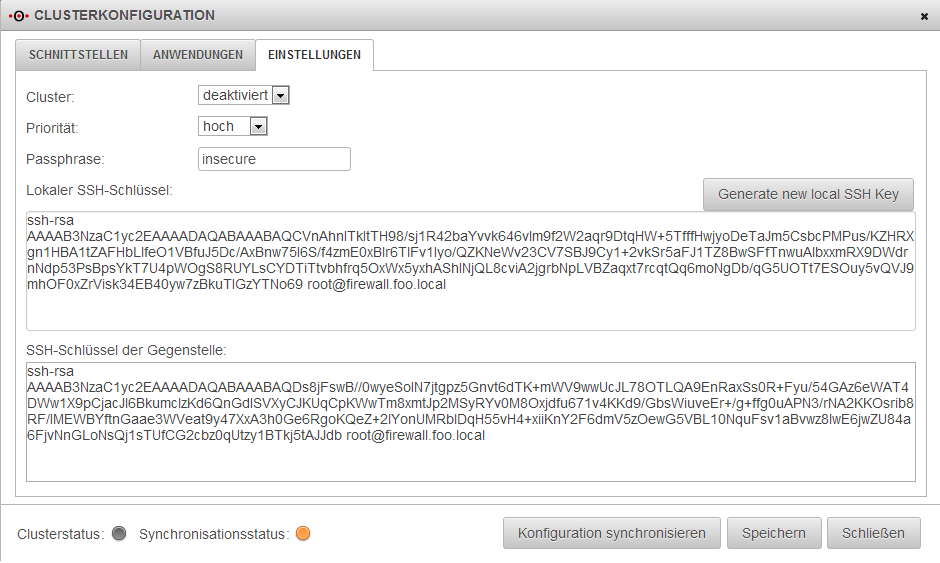

Unter dem Punkt Einstellungen erzeugen sie nun einen SSH Public Key und kopieren ihn in die Zwischenablage.

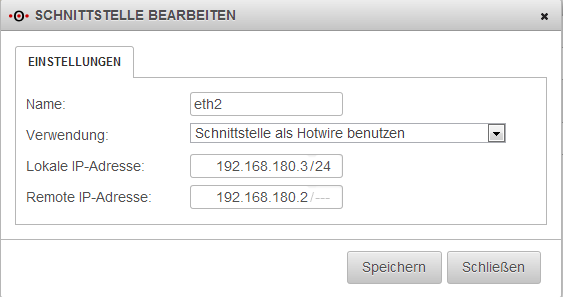

Nun wird es Zeit, die zweite UTM im Cluster zu konfigurieren. Loggen sie sich über die IP-Adresse 192.168.175.3 auf das Web-Interface ein. Öffnen sie den Dialog Clusterkonfiguration und bearbeiten sie die Schnittstelle eth2 um sie als Hotwire zu kennzeichnen. Geben sie in dem Dialog als lokale IP-Adresse 192.168.180.3/24 und als Gegenstelle die bereits konfigurierte UTM mit der IP-Adresse 192.168.180.2 ein.

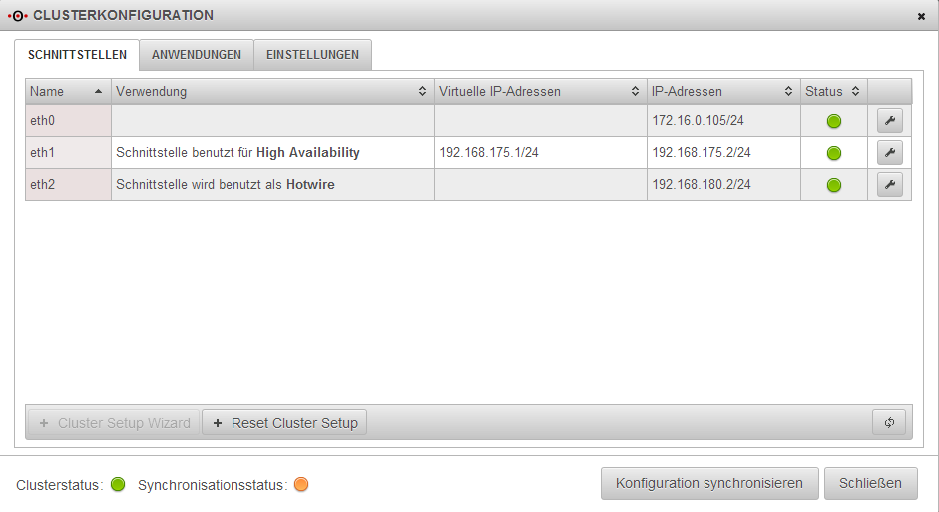

Wechseln sie danach in den Dialog Clusterkonfiguration -> Einstellungen und generieren dort ebenfalls einen SSH Key. Kopieren sie den SSH Key von der ersten UTM aus der Zwischenablage in das Feld „SSH-Schlüssel der Gegenstelle“. Wechseln sie auf die erste UTM und kopieren sie den SSH Key der zweiten UTM in das Feld „SSH-Schlüssel der Gegenstelle“. Auf beiden Seiten sollte sich nun ein lokaler SSH Schlüssel und jeweils der SSH Schlüssel der Gegenstelle gefinden. Speichern sie die Einstellungen auf beiden UTMs in diesem Dialog durch Betätigung der „Speichern“ Schaltfläche. Der Synchronisationsstatus sollte nun von rot auf orange wechseln. Das bedeutet, die beiden UTMs sehen sich über die Hotwire-Schnittstelle, aber die Konfiguration ist nicht synchronisiert.

Beachten sie bitte, dass der Status in bestimmten Intervallen aktualisiert wird. Wenn sie in dem Dialog „Schnittstellen“ die Aktualisierungs-Schaltfläche betätigen, können sie den Vorgang beschleunigen.

Loggen sie sich nun aus dem aus der zweiten Maschine aus und wechseln sie wieder in das WebInterface der ersten UTM, unserem Master. Betätigen sie nun den Button Konfiguration synchronisieren das erste Mal. Wenn die Synchronisation erfolgreich abgeschlossen wurde, steht jetzt der Synchronisationsstatus auf grün. Die beiden UTMs sind abgeglichen. Alles was sie auf der Master bereits konfiguriert haben, befindet sich jetzt auch auf der Backup Maschine. Sie können dies überprüfen, indem sie sich auf der Backup Maschine einloggen und die entsprechenden Dialoge öffnen. Da wir von der von uns definierten Master UTM die Synchronisation durchgeführt haben, wird die Cluster Priorität der zweiten Maschine (Backup) automatisch auf niedrig gestellt.

Würden sie die Priorität auf der jetzigen Backup UTM auf Hoch stellen und von da aus auch die Konfiguration synchronisieren, würde die erste Maschine automatisch zum Backup degradiert und die vormals Backup UTM zum Master.

Im letzen Schritt aktivieren Sie den Cluster. Schliessen sie die externen Interfaces an das DSL Modem an. Im Dialog Clusterkonfiguration, wechseln sie auf den Punkt Einstellungen und aktivieren sie den Cluster. Dieser Schritt muss auf beiden UTMs getrennt ausgeführt werden. Ihr Cluster ist nun in Betrieb und der Master des Clusters hat unsere virtuelle IP-Adresse 192.168.175.1 auf dem internen Interface.

Falls der Status nicht sofort aktualisiert wird, können sie auch hier wieder die Schaltfläche zum neu laden drücken.

Beispiel Konfiguration: Externer Router

In diesen Beispiel wird eine Konfiguration aufgezeigt wenn sie ein UTM Cluster an einem externen Router betreiben möchten. Der Router ist das Gateway zum Internet. Eventuell haben sie von ihrem Provider ein öffentliches Netz zur Verfügung gestellt bekommen. In unserem Beispiel verwenden wir ein privates Netz. Die Vorgehensweise ist dann analog. In diesem Beispiel werden wir zwei HA Schnittstellen konfigurieren. Für die interne und die externe Schnittstelle.

Netzwerkkonfiguration:

Erstes Mitglied des Clusters UTM 1:

Interne IP-Adresse:192.168.175.2/24

Externe IP-Adresse:172.16.0.105/24

Hotwire IP-Adresse:192.168.180.2/24

Zweites Mitglied des Clusters UTM 2:

Interne IP-Adresse: 192.168.175.3/24

Extern IP-Adresse:172.16.0.106/24

Hotwire IP-Adresse:192.168.180.3/24

Die Virtuellen IPs, die sich beide Mitglieder des Clusters teilen sollen, sind die IP-Adressen 192.168.175.1/24 für intern und 172.16.0.107/24 für extern. Die IP-Adresse 192.168.175.1 ist das Standard-Gateway des internen Netzwerks.

Inbetriebnahme der UTMs

Verwenden Sie für die Inbetriebnahme den Installations-Wizard der UTM. Die Konfiguration der beiden UTMs sollte sich bis zu diesem Zeitpunkt nur durch die interne und externe IP-Adresse unterscheiden. Importieren sie die erworbene Cluster-Lizenz im letzten Schritt des Wizards und starten sie die Maschinen nach Abschluss des Assistenten neu. Sind die beiden UTMs mit dem internen Switch verbunden, sollten sie nun von ihrem administrativen Client auf beide Geräte gelangen.

Hotwire Interface

Verbinden sie nun beide UTMs physikalisch mit dem von ihnen ausgewählten Hotwire Interface. Dieses muss auf den Maschinen der selbe Port sein, zum Beispiel LAN 3.

Cluster Konfiguration

Die UTMs haben innerhalb des Clusters eine unterschiedliche Priorität. Die höhere Priorität hat der Master, die Niedrigere das Backup-System. In unserem Beispiel wird die UTM mit der eindeutigen internen IP-Adresse 192.168.175.2 Master sein. Loggen sie sich auf diese Maschine mittels des Web-Interfaces ein.

Öffnen sie nun den Netzwerk-Dialog, zu finden unter dem Menüpunkt Netzwerk -> Netzwerkkonfiguration. Und fügen sie die IP-Adresse des zukünftigen Hotwire-Interfaces hinzu. In unserem Fall bekommt LAN3 (eth2) die IP-Adresse 192.168.180.2/24.

Im nächsten Schritt öffnen sie den Cluster Dialog (Netzwerk -> Clusterkonfiguration) und starten den Cluster Setup Wizard, wählen die Hotwire-Schnittstelle aus und geben die IP-Adresse der Hotwire-Gegenstelle an.

In Step 2 des Wizards wählen sie das zukünftige HA Interface aus. Wir beginnen mit der internen Schnittstelle. Die Virtuelle IP-Adresse soll 192.168.175.1/24 sein. Sie können auf eine HA-Schnittstelle auch mehrere virtuelle IP-Adressen setzen. Diese IP-Adressen müssen nicht in der gleichen Broadcast Domain der anderen IP-Adressen sein. Nachdem sie den Wizard durchlaufen haben, werde wir auch die weitere HA Schnittstellen konfigurieren.

Im Step 3 des Wizards werden Schnittstellen definiert, die auf dem Backup System (auch Spare genannt) nicht hochgefahren werden. In unserer Konfiguration haben wir keine solche Schnittstelle. Falls sie die Einwahl über ein DSL Modem machen wollen, welches direkt an der UTM terminiert ist, beachten sie bitte die Konfiguration im Abschnitt „Beispiel-Konfiguration: Externes DSL-Modem“.

Im nächsten Schritt können sie Applikationen definieren die auf dem Backup System nicht aktiv sein sollen. Das Verhalten entspricht dem Schritt 3. Wir wählen hier die Applikation DHCP Server aus, falls die UTM auch als DHCP Server agieren soll, sprich den Clients im internen Netz IP-Adressen vergeben soll. Falls sie eine UTM verwenden, die auch als Access Point dient, deaktivieren sie hier auch die Applikation WLAN-Server.

Im letzten Schritt des Wizards legen sie die Passphrase für die Kommunikation der beiden UTMs auf den HA Schnittstellen fest (VRR-Protokoll) und die Priorität. Wir möchten das diese UTM die höhere Priorität hat, sprich im Regelfall Master ist.

Die Konfiguration sieht nun wie folgt aus. Der Clusterstatus zeigt noch keinen Zustand an, weil der Cluster noch nicht auf aktiv geschaltet ist. Der Synchronisationsstatus steht auf rot, weil die Gegenstelle nicht erreichbar ist.

Unter dem Punkt Einstellungen erzeugen sie nun einen SSH Public Key und kopieren ihn in die Zwischenablage.

Nun wird es Zeit, die zweite UTM im Cluster zu konfigurieren. Loggen sie sich über die IP-Adresse 192.168.175.3 auf das Web-Interface ein. Öffnen sie den Dialog Clusterkonfiguration und bearbeiten sie die Schnittstelle eth2 um sie als Hotwire zu kennzeichnen. Geben sie in dem Dialog als lokale IP-Adresse 192.168.180.3/24 und als Gegenstelle die bereits konfigurierte UTM mit der IP-Adresse 192.168.180.2 ein.

Wechseln sie danach in den Dialog Clusterkonfiguration -> Einstellungen und generieren dort ebenfalls einen SSH Key. Kopieren sie den SSH Key von der ersten UTM aus der Zwischenablage in das Feld „SSH-Schlüssel der Gegenstelle“. Wechseln sie auf die erste UTM und kopieren sie den SSH Key der zweiten UTM in das Feld „SSH-Schlüssel der Gegenstelle“. Auf beiden Seiten sollte sich nun jeweils ein lokaler SSH Schlüssel und der SSH Schlüssel der Gegenstelle befinden. Speichern sie die Einstellungen auf beiden UTMs in diesem Dialog durch betätigen der „Speichern“ Schaltfläche. Der Synchronisationsstatus sollte nun von rot auf orange wechseln. Das bedeutet, die beiden UTMs sehen sich über die Hotwire Schnittstelle, aber die Konfiguration ist nicht synchronisiert.

Beachten sie bitte, dass der Status in bestimmten Intervallen aktualisiert wird. Wenn sie in dem Dialog „Schnittstellen“ die Aktualisierungs-Schaltfläche betätigen, können sie den Vorgang beschleunigen.

Loggen sie sich nun aus dem aus der zweiten Maschine aus und wechseln sie wieder in das Web-Interface der ersten UTM, unserem Master. Betätigen sie nun den Button Konfiguration synchronisieren das erste Mal. Wenn die Synchronisation erfolgreich abgeschlossen wurde, steht jetzt der Synchronisationsstatus auf grün. Die beiden UTMs sind abgeglichen. Alles was sie auf der Master bereits konfiguriert haben, befindet sich jetzt auch auf der Backup Maschine. Sie können dies überprüfen, indem sie sich auf der Backup Maschine einloggen und die entsprechenden Dialoge öffnen. Da wir von der von uns definierten Master UTM die Synchronisation durchgeführt haben, wird die Cluster Priorität der zweiten Maschine (Backup) automatisch auf niedrig gestellt.

Würden Sie die Priorität auf der jetzigen Backup UTM auf Hoch stellen und von da aus auch die Konfiguration synchronisieren, würde die erste Maschine automatisch zum Backup degradiert und die vormals Backup UTM zum Master.

Wechseln Sie nun auf den Punkt Einstellungen und aktivieren sie den Cluster. Dieser Schritt muss auf beiden UTMs getrennt ausgeführt werden. Ihr Cluster ist nun in Betrieb und der Master des Clusters hat unsere virtuelle IP-Adresse 192.168.175.1 auf dem internen Interface.

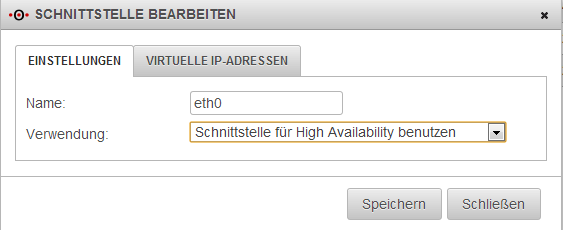

Nun muss noch die externe Schnittstelle auf HA Betrieb konfiguriert werden. Bearbeiten sie diese Schnittstelle in der Clusterkonfiguration und stellen sie das Interface im Dialog auf „Schnittstelle für High Availability benutzen“.

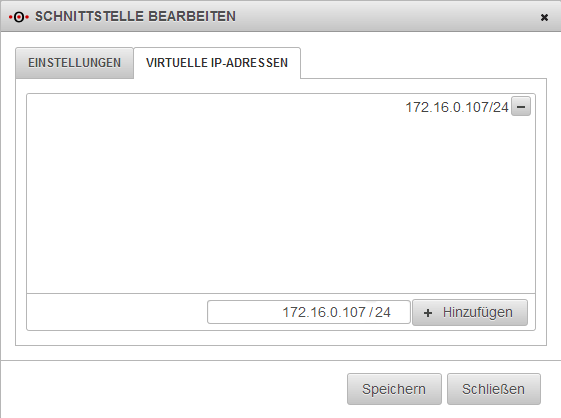

Im zweiten Reiter des Dialogs stellen sie die virtuelle IP-Adresse ein, die wir vorab ausgewählt haben.

Speichern sie die Einstellungen und synchronisieren sie den Cluster damit die zweite Maschine die gleiche Konfiguration besitzt. Die Konfiguration ist sofort aktiv und ihr Cluster konfiguriert.

NAT in der Cluster Konfiguration

In bestimmten Konstellationen ist es notwendig die NAT Einstellungen anzupassen. Wir beziehen uns hier auf das Beispiel „Cluster Konfiguration: Externer Router“.

Die externen IP-Adressen des Clusters sind in der selben Broadcast Domain und die Standardroute der UTMs zeigt auf den Router der die Internet Verbindung herstellt.

Externe IP UTM 1:172.16.0.105/24

Externe IP UTM 2:172.16.0.106/24

Virtuelle IP Cluster:172.16.0.107/24

IP des Routers:172.16.0.1/24

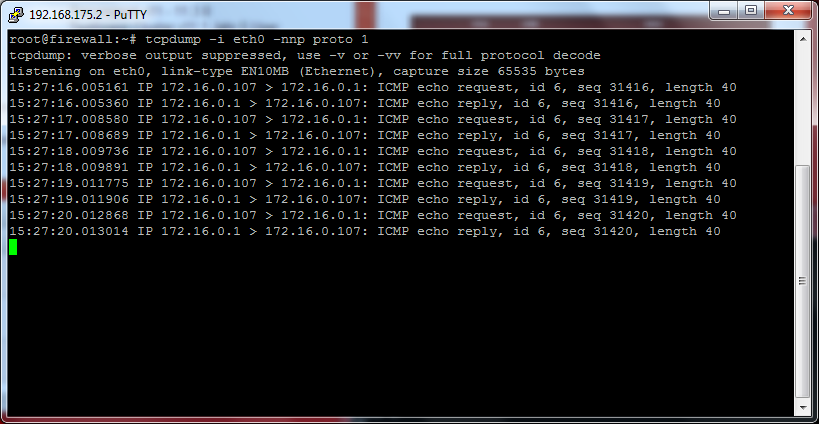

Die UTM 1 soll Master sein und besitzt die virtuelle IP-Adresse. Setzen wir nun einen ping aus dem internen Netz auf die IP-Adresse des Routers ab, sehen wir Folgendes im tcpdump der UTM1 auf dem externen Interface.

Der Ping wird von unserem Client im Standard-Regelwerk nicht über die virtuelle IP-Adresse des Clusters geNATet, sondern über die dem Master eindeutige IP-Adresse 172.16.0.105. Das kommt zustande, weil die eindeutige IP-Adresse die erste IP auf der Schnittstelle ist und der Router sich in der gleichen Broadcast Domain befindet. Wechselt der Cluster auf das Backup System, wird dort nicht mehr die IP-Adresse 172.16.0.105 sondern die IP-Adresse 172.16.0.106 stehen.

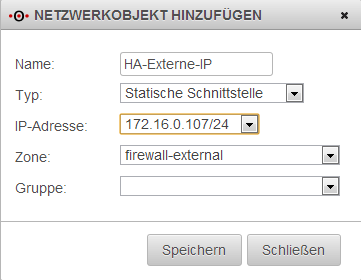

Um das zu ändern erstellen wir unter Firewall -> Portfilter -> Netzwerkobjekte ein neues Objekt mit der virtuellen IP-Adresse auf dem Cluster Interface.

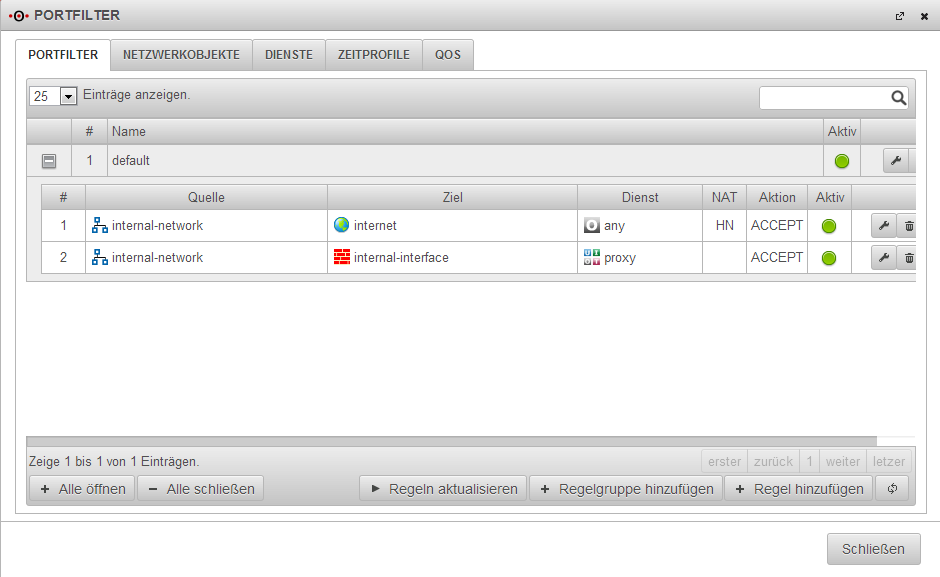

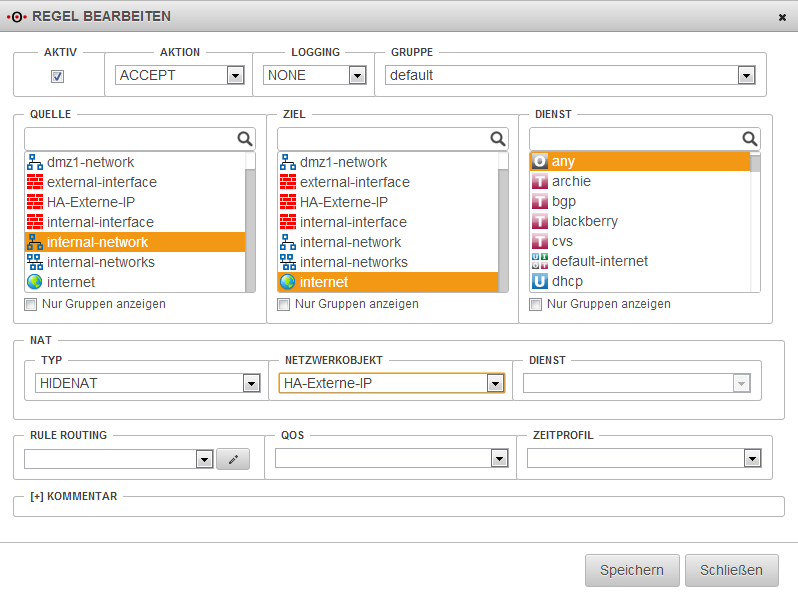

Wechseln sie in den Reiter Portfilter und bearbeiten sie die HideNAT Regel. In unserem Fall Regel Nummer 1.

Ersetzen sie das Objekt „external-interface“ durch ihr gerade erstelltes Objekt „HA-Externe-IP“. Speichern sie die Regel ab und aktualisieren sie das Regelwerk. Synchonisieren sie danach den Cluster.

Wenn sie den Ping Test wiederholen, sollten sie Folgendes sehen. Beachten sie: Wenn ihr Ping auf den Router ohne Unterbrechung lief, ist dieser noch im Conntrack gespeichert, der Ping wird also noch über die falsche IP-Adresse geNATet. Unterbrechen sie den Ping und warten sie mindestens 30 Sekunden. Starten sie den Ping dann neu.

Applikationen in der Cluster Konfiguration

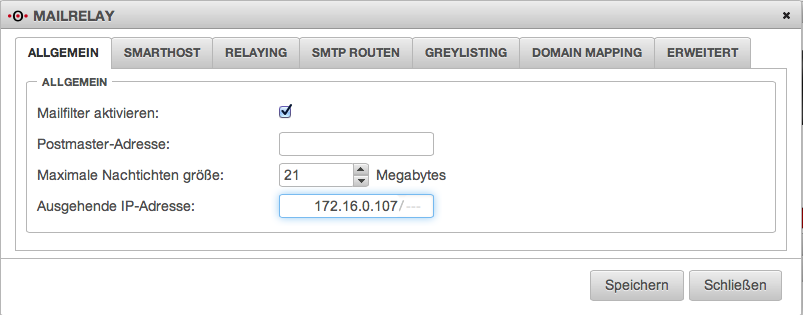

Ähnliches wie in dem Beispiel NAT in der Cluster Konfiguration kann auch für Applikationen zutreffen. Wir beziehen uns hier wieder auf die Cluster Konfiguration mit dem externen Router. Als Applikation nehmen wir uns das Mailrelay heraus.

Sie möchten E-Mails über das Mailrelay der UTMs verschicken und empfangen. Sie haben dazu entsprechende PTR, A, MX Records und SPF Einträge in den TXT Records ihrer Domain gemacht, die auf die externe virtuelle IP-Adresse des Clusters zeigen. Damit das Mailrelay nun auch E-Mails über diese virtuelle IP verschickt, müssen sie in der Applikation die ausgehende IP-Adresse korrekt einstellen. In unserem Fall die virtuelle IP 172.16.0.107.

Synchronisieren sie danach wieder die Cluster Konfiguration.

Kommunikation von Applikationen, die auf der Firewall laufen

Alle Applikationen, die von der Firewall selber eine Verbindung aufbauen, verwenden dafür (sofern nicht anders konfiguriert) die primären IPs der Schnittstellen. Sollten Sie Management-IPs aus der gleichen Broadcast-Domäne verwenden sind diese primären IPs nicht die virtuellen IP-Adressen.

Syslog

Das bedeutet, dass beispielsweise Syslog-Nachrichten von der Management-IP der Master verschickt werden, wenn diese die aktive Maschine im Cluster ist, und von der Management-IP der Spare wenn diese aktiviert wurde.

Folgende weitere Applikationen sind betroffen:

HTTP-Proxy

Sollte ein Parent-Proxy in Benutzung sein, der Verbindungen nur von einer bestimmten IP annimmt, muss diese unter „Anwendungen“ -> „HTTP-Proxy“ -> „Ausgehende Adresse“ angegeben werden.

Mailrelay

Bitte beachten Sie dazu die Hinweise im Abschnitt „Applikationen in der Cluster-Konfiguration“

RADIUS-/LDAP-/AD-Anbindung

Sollte der Server nur Verbindungen von bestimmten IPs zulassen, müssen auf dem Ziel-Server jeweils die Management-IPs beider Geräte freigegeben werden.

IPSec

Alle IPSec-Verbindungen müssen in Phase 1 so angepasst werden, dass im Feld „Local Gateway“ eine der virtuellen IPs fest eingetragen ist.

SSLVPN-Server

Alle SSLVPN-Server-Instanzen müssen so angepasst werden, dass unter „Einstellungen“ -> „Erweitert“ die Option „Multihome“ aktiviert ist.

SSLVPN-Clients

Alle SSLVPN-Client-Instanzen müssen so angepasst werden, dass Sie eine der virtuellen IPs zum Verbindungsaufbau verwenden. Führen Sie dazu folgende CLI-Befehle aus:

Zum Feststellen der ID der SSLVPN-Verbindung:

firewall> openvpn get

Zum Setzen der lokalen Adresse;

firewall> openvpn set id <ID> local_addr <VIRTUELLE-IP> local_port <FREIER-PORT>

Zum Aktivieren der Einstellungen:

firewall> appmgmt restart application openvpn

POP3 Proxy

Der POP3-Proxy kommuniziert immer mit der Management-IP, sofern diese in der gleichen Broadcast-Domain wie das Default-Gateway ist. Dies ist bei der Beschränkung des Zugriffs auf POP3-Server auf bestimmte IP-Adressen in deren Konfiguration zu beachten.

Clientless VPN

Verbindungen zu RDP/VNC-Servern werden immer mit den Management-IPs aufgebaut. Dies ist bei der Beschränkung des Zugriffs auf RDP/VNC-Server auf bestimmte IP-Adressen in deren Konfiguration zu beachten.

Nameserver

Verbindungen zu DNS-Servern werden immer mit den Management-IPs aufgebaut. Dies ist bei der Beschränkung des Zugriffs auf DNS-Server auf bestimmte IP-Adressen in deren Konfiguration zu beachten.

CLI Befehle

Im folgenden werden Befehle für die Securepoint CLI beschrieben.

CLI Befehle: cluster info

Ausgabe:

cluster_state:backup/master/none

Der Cluster State gibt an wer im Cluster gerade Master oder Backup ist oder ob der Cluster überhaupt aktiv ist. Die Ausgabe bezieht sich immer auf die Maschine, auf der dieser Befehl ausführt wird.

sync_state:synchronized/pending/error

Im welchen Zustand befindet sich die Konfiguration. Dabei bedeutet „synchronized“, das sie auf beiden UTMS des Clusters gleich ist. Der Zustand „pending“ bedeutet, die UTMs haben einen unterschiedlichen Stand. In beiden Fällen können die Mitglieder miteinander kommunizieren. Der Zustand „error“ weist darauf hin das sie keine Daten austauschen können. Das könnte der Fall sein, wenn kein Hotwire Interface konfiguriert ist, die Verkabelung nicht korrekt ist, die SSH Keys nicht ausgetauscht wurden, oder falsche SSH Keys verwendet werden.

hotwire_dev:ethx

Auf welchen Interface ist das Hotwire Interface konfiguriert.

CLI Befehl: system config synchronize

Durch diesen Befehl kann die Konfiguration über die Hotwire Schnittstelle an den Cluster Partner übertragen werden. Dabei wird die Konfiguration von der UTM verwendet, auf der sie den Befehl ausführen. Falls sie in der CLI eine Konfigurationsänderung durchgeführt haben, speichern sie diese erst lokal durch den CLI Befehl „system config save name <Name ihrer Konfiguration>“. Erst dann synchronisieren die Konfiguration des Clusters. Ansonsten wird die Änderung nicht übertragen.

CLI Befehl: extc value get application "securepoint_firewall" variable "UPDATE_TRIGGER_DELAY"

Zeigt den Delay in Sekunden an, bevor im Fehlerfall, von Master auf Backup geschaltet wird. Der Standardwert ist 2 Sekunden.

CLI Befehl: extc value set application "securepoint_firewall" variable "UPDATE_TRIGGER_DELAY" value 2

Verändert den Delay, für den Fehlerfall, das von Master auf Backup geschaltet wird. Der Standardwert ist 2 Sekunden und sollte nicht niedriger eingestellt werden. Falls ihre Appliances im Cluster eine hohe Grundlast haben sollten, stellen sie den Wert höher ein. Die Einstellung ist sofort aktiv und kann via „system config synchronize“ auf den Partner übertragen werden.

Einschränkungen

DHCP Client Interface und HA Interface kombinieren

Konfigurieren sie kein HA Interface auf einem Ethernet oder VLAN Interface auf dem sie DHCP Client konfiguriert haben, also die UTM auf dem Interface eine IP-Adresse dynamisch zugewiesen bekommt. Sollte der DHCP Server nicht erreichbar sein nachdem sie die UTM gestartet haben und ist sie in dem Augenblick auch der Master im Cluster, wird die virtuelle IP-Adresse vom Interface entfernt sobald der DHCP Server wieder erreichbar ist und die UTM eine neue IP-Adresse vom DHCP Server empfängt.

<references/>